1 概述

概率论,研究的是概率,数理统计以及随机过程的学科。

1.1 研究对象

在高等数学中,我们研究的是变量为数值的为积分问题。在线性代数中,我们研究的是变量为向量的线性变换问题。在概率论中,我们研究的是变量为随机数值的问题。在自然中,我们遇到的更多现象是随机的,和不确定的。

1.2 应用

概率论的应用范围很广,机器学习中有一条专门使用概率论来解决机器学习的问题——贝叶斯分支。主要的应用范围为

- 贝叶斯概率分析,通过先验概率推测后验概率的方法,在文章分类,垃圾邮件过滤中有广泛应用。

- 蒙特卡洛分析,通过概率的分析来简化计算微积分,以及最优化搜索的问题

- 极大似然估计,与高数的拉格朗日乘数法对应,是一个求数学模型的极值工具,不过它是站在概率的角度来考虑。

- 马尔可夫过程,一个神奇的随机过程,在语音识别,中文分词等离散的信号预测问题中有神奇作用。

2 概率论的基础

2.1 随机事件

2.1.1 随机试验

对随机现象作一次观察称为随机试验,这些试验具有以下特点:

- 可以在相同的条件下重复进行

- 每次试验可能出现的结果不止一个,但能事先明确试验的所有可能结果

- 试验完成前不能确定哪个结果会出现

称随机试验的所有可能结果构成的集合为样本空间,记为S,样本空间S中的每一个元素,即试验的每一个结果称为样本点

2.1.2 事件发生

当某一事件所包含的一个样本点发生时,我们就称这个事件发生

特别地,若把样本空间S亦视为一事件,因为S包含了试验所有的可能结果,因此在任何一次试验中,事件S一定会发生。我们称这种每次试验必然发生的事件为必然事件,用S来表示。与之相对应地,称在任何试验中都不可能发生的事件为不可能事件,记作\(\emptyset\)

2.1.3 事件包含

设A,B为同一样本空间S中的两个事件。若当事件B发生时一定导致A发生,则称事件A包含事件B,记为\(B \subset A\),同时又有\(A \subset B\),记为\(A=B\),即称事件A与B相等

2.1.4 和事件

设A,B为随机事件,\(A \cup B\)为一个新的事件。事件\(A \cup B\)包含了A和B所有的样本点,这些样本点发生时,\(A \cup B\)发生。故当事件\(A,B\)至少有一发生时,\(A \cup B\)发生。因此

\[ A \cup B = \{A与B至少有一个发生\} \]

为事件A与事件B的和事件。

从定义中可以看出,和事件就是其中一个事件至少发生。同理,有任意多个事件的和事件。

2.1.5 积事件

\[ A \cap B = \{A,B同时发生\} \]

为事件A与事件B的积事件,也可以表示为\(A \cdot B\),或表示成AB。

从定义可以看出,积事件就是所有事件都同时发生。同理,有任意多个事件的积事件。

2.1.6 逆事件

对于A不发生的事件,称为A的逆事件,记作\(\overline{A}\),即

\[ \overline{A} = \{A不发生\} \]

从定义可以看出,逆事件就是事件的对立面,而且,明显的有\(A \cup \overline{A} = S,A \cap \overline{A} = \emptyset\)。

2.1.7 差事件

A与B的差事件,记为A-B,即

\[ A -B =\{A发生同时B不发生\} \]

因此,\(A-B=A\overline{B}\),差事件也可以看成是积事件和逆事件的复合。

2.1.8 运算规则

和,交,逆事件具有以下的运算规则

- 交换律:\(A \cup B = B \cup A,A\cap B = B \cap A\)

- 结合律:\(A \cup (B \cup C) = (A \cup B)\cup C,A(BC) = (AB)C\)

- 分配律:\(A(B \cup C) = (AB)\cup(AC),(AB)\cup C = (A \cup C)(B \cup C)\)

这三个就像数域上的加法与乘法操作

2.1.9 德摩根定律

\[ \overline{\bigcup_{j=1}^{n} A_j} = \bigcap_{j=1}^{n}\overline{A_j}\\ \overline{\bigcap_{j=1}^{n} A_j} = \bigcup_{j=1}^{n}\overline{A_j} \]

注意,这是一个重要的定律,它指出了计算逆事件的计算关键。我们可以将求事件,转化为求它的逆事件。

2.1.10 互斥事件

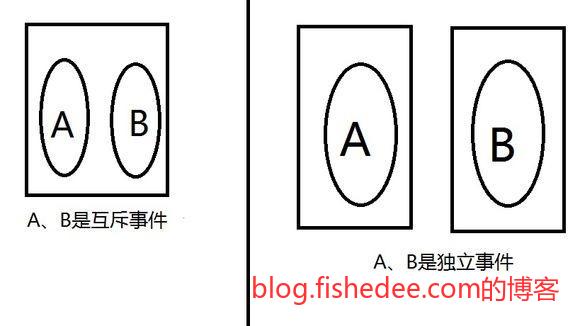

设A,B为两随机事件,当\(AB=\emptyset\)时,称事件A与事件B不相容(互斥)

注意,互斥事件就是A与B不存在两两发生的情况

2.2 概率

2.2.1 频率

在一定条件下,设事件A在n次重复试验中发生\(n_A\)次(称\(n_A\)次为A在这n次试验中发生的频数),称比值\(n_A/n\)为事件A在这n次试验中发生的频率,记为\(f_n(A)\)

\[ f_n(A) = \frac {n_A} {n} = \frac {A的发生次数} {总的试验次数} \]

从定义可以看出,频率是事件发生后统计出来的事件。如果事件不发生,就没有频率一说。

2.2.2 频率性质

频率具有以下性质

- 对任一事件A,\(0<= f_n(A)<=1\)

- \(f_n(S)=1\)

- 当事件A与B不相容时,\(f_n(A \cup B)=f_n(A)+f_n(B)\)

注意第三个性质。

2.2.3 概率

设某一随机试验所对应的样本空间S,对S中的任一事件A,定义一个实数P(A),满足以下三个公理:

- \(P(A) >=0\)

- \(P(S)=1\)

- 对S中的可列个两两不相容的事件\(A_1,A_2,\cdots,A_n,\cdots\),有

\[ P\left(\bigcup_{j=1}^{\infty} A_j\right) = \sum\limits_{j=1}^{\infty}P(A_j) \]

则称P(A)为A的概率,\(P(\cdot)\)为概率测度

这个定义对概率的定义可以说是非常非常的漂亮。首先,它没有说概率是频率在无限次情况下的极限。频率与概率的一个显著区别是,频率是事件发生后才有的统计值,而频率是事件发生前我们就知道了的数值。所以,不能说概率就是频率在无限次情况下的极限,因为概率在没有发生前就有的,我们根本不需要尝试无限次就能得到的结果。

另外,概率不是一个模糊的定论,它是从其数学性质上定义的事情。先有了它的性质,再进行它的定义。显然,概率与频率的性质是一样的,总体为一,不相容直接相加,但它不需要发生了才知道的事件。所以,概率从根本上来看,是一种测度,就是卷尺一样的测量工具。其将样本空间归一化(总概率为一),然后其样本点的概率值与样本大小成正比,的这样一个测量工具。所以,概率也被称为概率测度。

最后,概率隐含的一个事情时,我们对概率的确定是以保留最大熵的方式。例如,抛出一个硬币,事件A为正面,事件B为反面。根据概率的定义,我们知道一个概率测度可以是

\[ P(A) = \frac {1} {2}\\ P(B) = \frac {1} {2}\\ \]

这样确定满足概率的定义,而我们甚至可以定义

\[ P(A) = \frac {1} {4}\\ P(B) = \frac {3} {4}\\ \]

当然,这样也是满足概率的三个性质的,这是没有问题的,这样定义概率也是满足的。可是,为什么,我们都默认是第一个作为概率,而不是第二个作为概率。

如果说概率是频率趋向于无穷的极限,所以说取第一个。这样是不对的,因为事件没有发生,谁也不知道频率趋向于无穷的极限,可能硬币本来就是偏的呢,可能是第二个定义概率才是对的呢,所以这样解释第一个概率才是对的是没有道理的。

选择第一个的关键原因是,我们在满足概率的三个性质后,在确定概率值时,我们是依据保留事件的最大信息量,也就是熵为确定的。而保留需要保留事件的最大信息量,就需要将每个均等不相容的事件的概率设置为均等的概率。因此,在保留最大信息量的情况的隐含条件下,我们认为第一个概率才是正确的。

2.2.4 概率的逆公式

\[ P(A) = 1 - \overline{A} \]

证明:

\[ A \cup \overline{A} = S\\ P(A \cup \overline{A}) = S\\ 且A \cap \overline{A} = \emptyset\\ P(A) + P(\overline{A}) = P(S)\\ P(A) = 1 - P(\overline{A}) \]

所以,得证

2.2.5 概率的包含公式

当\(A \supset B\)时,必有\(P(A) >= P(B)\)

证明:

\[ A = AB\cup A\overline{B}\\ A=B \cup A\overline{B}\\ 又 B \cap A\overline{B} =\emptyset\\ P(A) = P(B) + P(A\overline{B})\\ P(A) - P(B) = P(A\overline(B))>=0\\ P(A) >= P(B) \]

所以得证

2.2.6 概率的和公式

\[ P(A\cup B) = P(A) + P(B) - P(A \cap B) \]

证明:

\[ A \cup B = AB \cup A\overline{B} \cup \overline{A}B\\ P(A \cup B) = P(AB) + P(A\overline{B}) +P(\overline{A}B)\\ P(A) = P(A\overline{B}) + P(AB)\\ P(B) = P(\overline{A}B)+P(AB)\\ P(A \cup B) = P(AB) + P(A) - P(AB) + P(B) - P(AB)\\ P(A \cup B) = P(A)+P(B) -P(AB) \]

所以,得证,同理,可以得到推广公式

\[ P(A\cup B \cup C) = P(A) + P(B) +P(C) - P(AB) - P(AC) - P(BC) + P(ABC)\\ \]

和

\[ P(\bigcup_{i=1}^{n}A_i)=\sum\limits_{i=1}^{n}P(A_i)-\sum\limits_{i<j}P(A_iA_j)+\sum\limits_{i<j<k}P(A_iA_jA_k)-\cdots+(-1)^{n-1}P(A_1A_2\cdots A_n) \]

这个定理非常重要,概率定义中只提供了对于不相容事件和的概率公式,但是没有提供对于任意事件和的概率公式。

2.2.7 概率的差公式

\[ P(A- B) = P(A) - P(AB) \]

证明:

\[ P(A-B)=P(A\overline{B})\\ = P(A) - P(AB)\\ \]

所以得证,这个定理是利用概率差事件转化为积事件来求解的

2.3 古典概型

2.3.1 古典概型

一个随机试验,如果满足下面的两个条件:

- 样本空间中样本点数有限(有限性)

- 出现每一个样本点的概率相等(等可能性)

则称这个试验问题为古典概型,又称等可能概型

2.3.2 古典概型的概率

若设一等可能概型的样本空间\(S=\{e_1,e_2,\cdots,e_n\}\),则由概率定义可知\(P(\{e_i\})=\frac {1} {n},i=1,2,\cdots,n\)。任一随机事件\(A=\{e_{i_1},e_{i_2},\cdots,e_{i_l}\}\),即\(A=\{e_{i_1}\}\cup\{e_{i_2}\}\cup \cdots \cup \{e_{i_l}\}\)。由样本点两两不相容的性质,知

\[ P(A) = P(\bigcup_{j=1}^{l}\{e_{i_j}\})=\sum\limits_{j=1}^{l} P(\{e_{i_j}\})=\frac l n \]

也就是说,在等可能概型中,任一事件A的概率为

\[ P(A) = \frac {A所包含的样本总数} {S中总样本总数} \]

古典概率归根到底还只是一个组合数学的数数字问题,结合概率的和公式,古典概率就可以解决很多的概率问题了。

2.4 条件概率

2.4.1 条件概率

如果\(P(A)>0\),那A发生的条件下的B的条件概率为

\[ P(B \vert A) = \frac {P(AB)} {P(A)} \]

条件概率的本质上就是在缩小了样本空间后的事件概率,由于条件概率只是缩小了样本空间,所以普通概率的性质也适用于条件概率,例如

\[ P(B \vert A) = P(A) - P(\overline{B} \vert A)\\ P(B \cup C \vert A) = P(B \vert A) + P(C \vert A) - P(BC \vert A) \]

2.4.2 概率的乘法公式

由条件概率的定义知,当\(P(A) \neq 0,P(B) \neq 0\)时

\[ P(AB) = P(A) \cdot P(B \vert A)=P(B) \cdot P(A \vert B) \]

即两个事件积事件的概率等于一个事件的概率乘以在这个事件发生的条件下另外一个事件的条件概率,称此等式为概率的乘法公式。同理,我们可以推广得

\[ P(A_1A_2\cdots A_n) = P(A_1)P(A_2\vert A_1)P(A_3\vert A_1A_2)\cdots P(A_n\vert A_1A_2\cdots A_{n-1}) \]

注意,这个公式是分解积事件求概率的重要公式。在很多时候,我们在计算条件概率时更为简单,这时候套积公式就比较重要了。

这个公式跟概率的和公式一样重要,这两个公式集合在一起就可以将任意的多事件概率问题转化为单事件的概率公式。

2.4.3 划分

设S为某一随机试验的样本空间,\(B_1,B_2,\cdots,B_n\)为该试验的一组事件,且满足

- \(B_iB_j = \emptyset,i,j=1,2,\cdots,n,i\neq j\)

- \(B_1 \cup B_2 \cup \cdots \cup B_n = S\)

则称\(B_1,B_2,\cdots,B_n\)为S的一个划分,或称为S的一个完备事件组

划分就是将样本空间切开成多个而已。

2.4.4 全概率公式

设S为某一试验的样本空间,A为该试验的事件。设\(B_1,B_2,\cdots,B_n\)是S的一个划分,且\(P(B_j)>0,j=1,2,\cdots,n\),则

\[ P(A) = \sum\limits_{j=1}^{n} P(B_j)P(A\vert B_j) \]

这个公式称为概率的全概率公式

证明:

\[ A = AB_1\cup AB_2 \cup \cdots AB_n\\ P(A) = P(AB_1)+ P(AB_2) + \cdots +P(AB_n)\\ P(A) = P(B_1)P(A \vert B_1)+ P(B_2)P(A \vert B_2) + \cdots +P(B_n)P(A \vert B_n) \]

所以得证

这个公式将事件的概率划分为多个样本空间下的条件概率之和,同理的,有相应的条件概率的全概率公式

\[ P(A \vert C) = \sum\limits_{j=1}^{n}P(B_j\vert C) P(A \vert B_j C) \]

2.4.5 贝叶斯公式

设S为某一试验的样本空间,A为该试验的事件,且\(P(A) \neq 0\),设\(B_1,B_2,\cdots,B_n\)是S的一个划分,且\(P(B_j)>0,j=1,2,\cdots,n\),则对任意\(k=1,2,\cdots,n\),有

\[ P(B_k\vert A) = \frac {P(B_kA)} {P(A)}=\frac {P(B_k)P(A\vert B_k)} {\sum\limits_{j=1}^{n} P(B_j) P(A\vert B_j)} \]

这个公式称为概率的贝叶斯公式。

在利用贝叶斯公式时,\(P(B_k)\)的概率是事先假设的,\(P(A\vert B_k)\)是实验收集的,\(P(B_k \vert A)\)是计算出来的,所以,一般称\(P(B_k)\)是先验概率,\((B_k \vert A)\)是后验概率。

这个公式在应用上非常广泛,它是整个贝叶斯推理的基础。它的神奇之处在于它可以将条件样本与条件事件的先后次序反过来。例如,如果我们知道,垃圾邮件跟“打字员”这个字有关。而在垃圾邮件中,“打字员”出现的概率为0.1,正常邮件,“打字员”出现的概率为0.001,而当我们下一次遇到一个新邮件时,出现“打字员”这个词,那么这个邮件是垃圾邮件的概率为多少呢。

在这个问题中,我们知道两个条件概率,P(打字员|垃圾邮件)=0.1,P(打字员|正常邮件)=0.001,但我们要求的是P(垃圾邮件|打字员)的概率。我们可以套入贝叶斯公式

\[ P(垃圾邮件\vert 打字员) = \frac {P(垃圾邮件)P(打字员\vert 垃圾邮件)} {P(垃圾邮件)P(打字员\vert 垃圾邮件)+P(正常邮件)P(打字员\vert 正常邮件)} \]

套入公式就可以得到了,相当神奇。但是在公式中,我们都没有P(垃圾邮件)和P(正常邮件)的概率,这个是需要我们先验经验来确定的。所以,贝叶斯推理的一个重大缺陷是过度依赖先验概率。

2.5 独立事件

2.5.1 事件独立

设A,B为两随机事件,当

\[ P(AB) = P(A) \cdot P(B) \]

成立时,称事件A,B相互独立.

注意,独立与互斥是不一样的,一个直接的不同是,互斥事件\(P(AB)=\emptyset\),独立事件\(P(AB)=P(A) \cdot P(B) \neq \emptyset\)。独立事件是概率乘法公式的一个特殊情况,但也是普遍情况。

2.5.2 事件独立的条件概率性质

当\(P(A) \cdot P(B) \neq 0\)时,事件A与事件B相互独立等价于条件概率等于无条件概率,即

\[ P(B \vert A)=P(B) \\ P(A \vert B) = P(A) \]

证明:

\[ P(AB) = P(A) \cdot P(B \vert A) \\ P(AB) = P(A) \cdot P(B)\\ P(B \vert A) = P(B)\\ \]

所以,得证

2.5.3 事件独立的逆事件性质

当事件A与事件B相互独立时,A与\(\overline{B}\),\(\overline{A}\)与B,\(\overline{A}\)与\(\overline{B}\)均相互独立

证明:

\[ P(A\overline{B}) = P(A)-P(AB)\\ = P(A) - (P(A)\cdot P(B))\\ = P(A)(1-P(B))\\ = P(A)P(\overline{B}) \]

所以,A与\(\overline{B}\)相互独立,其他的以此类推,所以得证。

2.5.4 相互独立与两两独立

设A,B,C为三个随机事件,当

\[ P(AB)=P(A)\cdot P(B)\\ P(AC)=P(A) \cdot P(C)\\ P(BC)=P(B) \cdot P(C)\\ \]

都成立时,称事件A,B,C两两独立

如果同时满足\(P(ABC)=P(A)\cdot P(B) \cdot P(C)\)则称事件A,B,C相互独立。

在三元以上的随机变量时,就会有两两独立与相互独立的区分。

注意,相互独立是四个条件,而不是一个条件

\[ \begin{cases} P(AB)=P(A)\cdot P(B)\\ P(AC)=P(A) \cdot P(C)\\ P(BC)=P(B) \cdot P(C)\\ P(ABC)=P(A)\cdot P(B) \cdot P(C)\\ \end{cases} \]

两两独立是三个条件

\[ \begin{cases} P(AB)=P(A)\cdot P(B)\\ P(AC)=P(A) \cdot P(C)\\ P(BC)=P(B) \cdot P(C)\\ \end{cases} \]

所以,显然,相互独立是比两两独立更强的性质,当相互独立时,必定两两独立,两两独立时,不一定能相互独立。

2.5.5 独立试验

假设所考虑的概率试验是由一系列子试验组成,若任何一次试验中各结果发生的可能性都不受其它各次试验结果发生情况的影响,则称这次试验是独立试验。如果各子试验是在相同条件下进行的,那我们就称这些试验为重复试验。

重复比独立试验增加了相同条件进行的条件。

3 单元随机变量

3.1 随机变量

设随机试验的样本空间为\(S=\{e\}\),若\(X=X(e)\)为定义在样本空间S上的实值单值函数,则称\(X=X(e)\)为随机变量。

随机变量是数学中的一种对随机现象的抽象工具,我们之前在推算概率时使用的是事件的方式,例如,抛四次硬币,求四次中出现正面次数的和的概率。

用事件来描述,就是令\(A_1,A_2,A_3,A_4\)分别为四次的出现正面的事件,那么\(B_0\)为四次中和为0的概率,显然\(P(B_0)=P(\overline{A_1}\cdot\overline{A_2}\cdot\overline{A_3}\cdot\overline{A_4})\),然后

\[ P(B_1)=P(A_1\cdot\overline{A_2}\cdot\overline{A_3}\cdot\overline{A_4})\\ +P(\overline{A_1}\cdot A_2\cdot\overline{A_3}\cdot\overline{A_4})\\+P(\overline{A_1}\cdot\overline{A_2}\cdot\ A_3\cdot\overline{A_4})\\+P(\overline{A_1}\cdot\overline{A_2}\cdot\overline{A_3}\cdot A_4) \]

我们将\(B_1,B_2,B_3,B_4\)分解为A的事件,然后利用概率的和公式来求解。显然,这个过程有很多冗余的写法,并且没有将B与A的本质关系用数学语言来描述。

用随机变量来描述,就是令\(X_1,X_2,X_3,X_4\)分别为每次出现正面的次数的随机变量,那么\(Y=X_1+X_2+X_3+X_4\)就是我们要求的随机变量的分布律。随机变量能用数学语言来描述事件之间的本质关系,从而使得我们能套很多随机变量的公式。

另外,事件无法解决连续无限样本空间的概率问题。例如,我向一个正方形(长宽为1)投下一根针,求这根针在这个正方形的内含圆形的概率。

如果用概率的方式,就是

\[ P(B) = P(A_{0,0} \cup A_{0.1,0.1} \cup A_{0.01,0.01}) \]

事件太多,而且无法罗列完全,而且更惨的是每个样本的概率接近为0。无限多个无限小的样本和的概率究竟是多少,根本不知道。

如果用随机变量的方式,就是

\[ P(C) = P(X^2+Y^2<=1) \]

的概率,相当直观和简单。

所以,随机变量是从古典概率走向现代概率的重要工具。

3.2 离散型随机变量

3.2.2 概率分布律

设X为离散量,若其取值为\(x_1,x_2,\cdots,x_k,\cdots\),则称

\[ P\{X=x_k\}=p_k,k=1,2,\cdots \]

为X的概率分布律

就是将状态空间中的所有样本点概率直接列出来,就可以了

3.2.3 概率分布律的性质

概率分布律的性质

- \(p_k >=0,k=1,2,\cdots\)

- \(\sum\limits_{k=1}^{+\infty}p_k=1\)

显然性质,直接套概率定义就可以了

3.2.4 离散型随机变量

若随机变量的取值为有限个或可列个,则称此随机变量为离散型随机变量,简称离散量。

注意是有限或可列,而不仅仅是有限个

3.2.5 0-1分布

若随机变量X的概率分布律为

\[ \begin{array}{c|lcr} X & \text{0} & \text{1} \\ \hline\\ p & 1-p & p\\ \end{array} \]

其中,\(0<p<1\),则称X为服从参数为p的0-1分布,也称为两点分布,并用记号\(X \sim B(1,p)\)表示

3.2.6 二项分布

若随机变量X的概率分布律为

\[ P\{X=k\} = C_{n}^{k}p^{k}(1-p)^{n-k},k=0,1,2,\cdots,n \]

其中,\(0<p<1,n>=1\),则称X服从参数为(n,p)的二项分布,且记为\(X \sim B(n,p)\)

推导:

\[ \sum\limits_{k=0}^{n}P(X=k)\\ = \sum\limits_{k=0}^{n}C_{n}^{k}p^{k}(1-p)^{n-k}\\ = [p+(1-p)]^{n}\\ = 1\\ \]

另外,在n次独立重复的试验中,每次试验都只有两个结果\(A,\overline{A}\),且每次试验中A发生的概率不变,记为\(P(A)=p,0<p<1\),称这一系列试验为n重贝努里试验。显然,在n重贝努里试验中,若记事件A发生的概率为P(A)=p,0<p<1。设X为n次试验中A发生的次数,则\(X \sim B(n,p)\)

3.2.7 泊松分布

若随机变量X的概率分布律为

\[ P\{X=k\}= \frac {e^{-\lambda}\lambda^{k}} {k!},k=0,1,2,\cdots \]

其中\(\lambda >0\),则称X服从参数为\(\lambda\)的泊松分布,且记为\(X \sim \pi(\lambda)\)

推导:

\[ \sum\limits_{k=0}^{n}P(X=k)\\ = \sum\limits_{k=0}^{n}\frac {e^{-\lambda}\lambda^{k}} {k!}\\ = e^{-\lambda}\sum\limits_{k=0}^{n}\frac {\lambda^{k}} {k!}\\ = e^{-\lambda}e^{\lambda}\\ = 1\\ \]

另外,在二项分布\(X \sim B(n,p)\)中,当n充分大,而p充分小(p<0.1)时,二项分布近似于泊松分布\(X \sim \pi(np)\)

\[ P\{X=k\}=C_{n}^{k} p^{k} (1-p)^{n-k}\\ = \frac {n!} {k!(n-k)!}p^{k}(1-p)^{n-k}\\ = \frac {n!} {k!(n-k)!}(\frac \lambda n )^{k}(1-\frac \lambda n)^{n-k}\\ = \frac {n!} {(n-k)!n^{k}}\cdot\frac {\lambda ^k} {k!}\cdot \frac { {1- \frac \lambda n}^{n} } { {1- \frac \lambda n}^{k} }\\ \approx 1 \cdot \frac {\lambda ^k} {k!}\cdot \frac { {e}^{-\lambda} } {1} \]

所以得证

3.2.8 几何分布

设独立重复试验中,每次试验有两个结果:\(A,\overline{A}\)。每次试验中A出现的概率不变,记为\(P(A)=p,0<p<1\),设直至A首次发声时所需的试验次数为X,X的概率分布律为

\[ P\{X=k\}=(1-p)^{k-1}p \]

则称X服从参数为p的几何分布,记为\(X \sim Geo(p)\)

3.2.9 超几何分布

设随机试验中,共有N个随机对象,a个属于目标对象,b个属于非目标对象,设X为不放回地抽取n个对象,其中X个属于a对象的概率

\[ P\{X=k\} = \frac {C_a^kC_b^{n-k}} {C_N^n},k=l_1,l_1+1,\cdots,l_2 \]

其中\(l_1=\max(0,n-b),l_2=\min(a,n)\)

则称X服从超几何分布

3.3 随机变量的分布函数

3.3.1 概率分布函数

设X为一随机变量,x为任意实数,函数

\[ F(x) = P\{X<=x\} \]

称为随机变量X的概率分布函数,简称分布函数

注意,无论是离散型随机变量,还是连续型随机变量都有概率分布函数,只是离散型随机变量是概率分布律,连续型随机变量是概率密度函数。

另外,概率分布函数解决了表征无限样本的概率问题的方法。如果状态空间是无限的,那么每一个样本点所分得的概率都是无限小的,可以看成是0。但是某个区间或某个区域的概率就肯定是存在的,那么如果我们知道概率分布函数,就能求得任意区间的概率了。

\[ P\{x_1<X<=x_2\}=P\{X<=x_2\}-P\{X<=x_1\}=F(x_2)-F(x_1) \]

这样我们就能以类似于概率分布律的方式来描述任意一点的概率权重了。

3.3.2 概率分布函数的性质

概率分布函数的性质

- F(x)单调不减

- 0<=F(x)<=1,且有\(\lim\limits_{a \to -\infty} F(a)=0,\lim\limits_{b \to + \infty} F(b) = 1\),简记为\(F(-\infty)=0,F(+\infty)=1\)

- F(x+0)=F(x),即F(x)是右连续函数

直接套定义就好了,不难

3.4 连续型随机变量

3.4.1 连续型随机变量

对于随机变量X,若存在一个非负的实函数f(x),使X落在任一区域D上的概率

\[ P\{X \in D\} = \int_{D} f(x)dx \]

则称X为连续型随机变量,简称连续量。称f(x)为X的概率密度函数,简称密度。

在连续型随机变量中,任意一点的概率为0。但任意一点的概率密度不为0,因此,这一点的密度大小会影响所包含区域的概率值。

另外,根据定义,可知对于任意区域D=[a,b],则有

\[ P\{a<=X<=b\} = \int_{a}^{b} f(x)dx \]

并且,区间的开闭性均不影响概率值。

3.4.2 概率密度函数

概率密度函数具有以下的性质

- \(f(x) >= 0\)

- \(\int_{-\infty}^{+\infty} f(x) dx =1\)

- X的概率分布函数\(F(x)=\int_{-\infty}^{x} f(t)dt\)

- 在f(x)的连续点x处,\(F'(x)=f(x)\)

3.4.3 均匀分布

设随机变量X具有概率密度

\[ f(x) = \begin{cases} \frac {1} {b-a},x \in(a,b)\\ 0,其他 \end{cases} \]

则称X服从区间\((a,b)\)上均匀分布,常记为\(X \sim U(a,b)\)。显然,X的概率分布函数为

\[ F(x) = \begin{cases} 0,x<a\\ \frac {(x-a)} {(b-a)},a<=x<b\\ 1,x>=b \end{cases} \]

推导:

\[ \int_{-\infty}^{+\infty}f(x)dx\\ = \int_{a}^{b} \frac {1} {b-a}dx\\ = \left. \frac {x} {b-a} \right\vert_{a}^{b}\\ = 1 \]

3.4.4 正态分布

设随机变量X具有概率密度

\[ f(x) = \frac {1} {\sqrt{2\pi}\cdot \sigma}e^{-(x-\mu)^2/(2\sigma^2)},\lvert x \rvert < +\infty \]

其中参数\(\sigma > 0,\lvert \mu \rvert < + \infty\),则称X服从参数为\((\mu,\sigma)\)的正态分布,或简称X为正态量,记为\(X \sim N(\mu,\sigma^2)\),其相应的分布函数为

\[ F(x) = \int_{-\infty}^{x}\frac {1} {\sqrt{2\pi}\cdot \sigma}e^{-(t-\mu)^2/(2\sigma^2)}dt \]

推导:

令\(t = \frac {x-\mu} {\sigma}\)

\[ I = \int_{-\infty}^{+\infty}\frac {1} {\sqrt{2\pi}\cdot \sigma}e^{-(x-\mu)^2/(2\sigma^2)}dx\\ = \int_{-\infty}^{+\infty} \frac {1} {\sqrt{2\pi}\cdot \sigma}e^{-(t\sigma)^2/(2\sigma^2)}d(t\sigma+\mu)\\ = \int_{-\infty}^{+\infty} \frac {1}{\sqrt{2\pi}}e^{-t^2/2}dt\\ I^2 = \int_{-\infty}^{+\infty} \frac {1}{\sqrt{2\pi}}e^{-t^2/2}dt\int_{-\infty}^{+\infty} \frac {1}{\sqrt{2\pi}}e^{-t^2/2}dt\\ =\int_{-\infty}^{+\infty} \frac {1}{\sqrt{2\pi}}e^{-x^2/2}dx\int_{-\infty}^{+\infty} \frac {1}{\sqrt{2\pi}}e^{-y^2/2}dy\\ =\int_{-\infty}^{+\infty}\frac {1}{2\pi}e^{-(x^2+y^2)/2}dxdy\\ \]

将积分变量从直角坐标系变为极坐标系,得

\[ I^2=\int_{0}^{2\pi}d\theta\int_{0}^{+\infty}r\cdot \frac {1} {2\pi}e^{-r^2/2}dr\\ = \int_{0}^{2\pi}d\theta(\left. \frac {-e^{-r^2/2}} {2\pi}\right\vert_{0}^{+\infty})\\ = \int_{0}^{2\pi}\frac {1} {2\pi}d\theta\\ = \left.\frac {\theta} {2\pi}\right\vert_{0}^{2\pi}\\ = 1\\ \]

所以

\[ I = \sqrt{I^2}=1 \]

因此,得证

证明的过程相当巧妙,将一元积分变为二元积分,然后套用极坐标系变换。

3.4.5 正态分布性质

正态分布具有以下的性质:

- f(x)关于\(x=\mu\)对称

- \(\max\limits_{\lvert x \rvert<+\infty}f(x) = f(\mu)=\frac {1} {\sqrt{2\pi}\sigma}\)

- \(\lim\limits_{\lvert x - \mu \rvert \to +\infty} f(x) = 0\)

也就是,概率密度关于\(\mu\)对称,且\(\mu\)位置为最大,远离\(\mu\)位置密度减少,直到0.

特别地,当\(\mu=0,\sigma=1\)时,若记这时的正态量为Z,\(Z \sim N(0,1)\),称Z服从标准正态分布,其概率密度为

\[ f(t) = \frac {1} {\sqrt{2\pi}}e^{-t^2/2} \]

相应的分布函数为

\[ \Phi(x) = \int_{-\infty}^{x}\frac {1} {\sqrt{2\pi}}e^{-t^2/2}dt \]

另外,有:

- \(\Phi(x)+\Phi(-x)=1\)

- 对于\(X~N(\mu,\sigma)\),\(P\{a<X<b\}=\Phi(\frac {b-\mu} {\sigma})-\Phi(\frac {a-\mu} {\sigma})\),

- 对于\(X~N(\mu,\sigma)\),\(P\{\lvert x - \mu \rvert< k\}=\Phi(\frac {k} {\sigma})-\Phi(-\frac {k} {\sigma})=2\Phi(\frac {k} {\sigma})-1\),

3.4.6 指数分布

设随机变量X具有概率密度

\[ f(x)=\begin{cases} \lambda e^{-\lambda x},x>=0\\ 0,x<=0\\ \end{cases} \]

其中\(\lambda >0\),则称X服从参数为\(\lambda\)的指数分布,记为\(X \sim E(\lambda)\)

推导:

\[ \int_{-\infty}^{+\infty}f(x)dx\\ = \int_{-\infty}^{+\infty}\lambda e^{-\lambda x}dx\\ = \left.-e^{-\lambda x}\right\vert_{0}^{+\infty}\\ = 1 \]

其相应的分布函数为

\[ F(x) =\int_{-\infty}^{x}f(t)dt\\ = \int_{0}^{x} \lambda e^{-\lambda t}dt\\ = \left.-e^{-\lambda t}\right\vert_{0}^{x}\\ = 1-e^{-\lambda x} \]

3.4.7 指数分布的性质

当\(X \sim E(\lambda)\)时,对任意的\(t>0,t_0>0\),有

\[ P\{X>t_0+t\vert X>t_0\}=\frac {P\{X>t_0+t\}}{P\{X>t_0\}}\\ = \frac {1-F(t_0+t)} {1-F(t_0)}\\ = e^{-\lambda t}\\ = P\{X>t\}\\ P\{X>t_0+t\vert X>t_0\}P\{X>t_0\}=P\{X>t\}P\{X>t_0\}\\ P\{X>t_0+t\}=P\{X>t\}P\{X>t_0\}\\ \]

因此指数分布在任意两个时段内的概率等于分别两个独立时段概率的乘积

3.4.8 Gamma分布

设随机变量X具有概率密度

\[ f(x) = \begin{cases} \beta e^{-\beta x}\frac {(\beta x)^{\alpha-1}}{\Gamma(\alpha)},x>0\\ 0,x<=0\\ \end{cases} \]

其中参数\(\alpha>0,\beta>0\),则称X服从参数为\((\alpha,\beta)\)的\(\Gamma\)分布,记为\(X \sim \Gamma(\alpha,\beta)\)

方程中的\(\Gamma(\alpha) = \int_{0}^{\infty} e^{-x}x^{\alpha-1}dx\),且有\(\Gamma(\alpha)=(\alpha-1)\Gamma(\alpha-1)\)。特别地,当n为正整数时,有\(\Gamma(n)=(n-1)!\)

推导:

\[ \int_{0}^{\infty} \beta e^{-\beta x}\frac {(\beta x)^{\alpha-1}}{\Gamma(\alpha)}dx\\ = \beta^{\alpha} \frac {\int_{0}^{\infty}e^{-\beta x}x^{\alpha-1}dx}{\Gamma(\alpha)}\\ = \beta^{\alpha} \frac {\int_{0}^{\infty}e^{-\beta x}x^{\alpha-1}dx}{\int_{0}^{\infty} e^{-x}x^{\alpha-1}dx}\\ = \beta^{\alpha} \cdot \frac {1} {\beta ^\alpha} \frac {\int_{0}^{\infty}e^{-\beta x}(\beta x)^{\alpha-1}d(\beta x)}{\int_{0}^{\infty} e^{-x}x^{\alpha-1}dx}\\ = \beta^{\alpha} \cdot \frac {1} {\beta ^\alpha}\cdot 1\\ = 1\\ \]

3.4.9 Beta分布

记随机变量X具有概率密度

\[ f(x) = \begin{cases} \frac {\Gamma(a+b)} {\Gamma(a)\Gamma(b)}x^{a-1}(1-x)^{b-1},0<=x<1\\ 0,其他 \end{cases} \]

其中参数a>0,b>0,则称X服从参数为(a,b)的\(\beta\)分布,记为\(X \sim \beta(a,b)\)

3.4.10 威布尔分布

设随机变量X具有概率密度

\[ f(x) = \begin{cases} \frac {\gamma} {\alpha}(\frac {x} {\alpha})^{\gamma-1}e^{-(x/\alpha)^{\gamma}},x>=0\\ 0,x<0 \end{cases} \]

其中参数\(\alpha>0,\gamma>0\),则称X服从参数为\((\alpha,\gamma)\)的二参数威布尔分布

3.5 随机变量函数

3.5.1 随机变量函数的分布

在已知X的分布,求Y=g(x)的分布,称为一个随机变量函数的分布问题。

当X的分布已知,Y=g(X),且Y为离散量时,可先列出Y的可能取值\(y_1,y_2,\cdots,y_k,\cdots\),然后找出事件\(\{Y=y_k\}\)的等价事件\(\{X \in D_k\}\),从而求出Y的分布律\(P\{Y=y_k\}=P\{X \in D_k\}\)即可。

当Y=g(x)为连续量时,我们总是先求出\(\{Y<=y\}\)(因为Y是连续量,所以我们不去求概率分布律\(P(Y=y)\),而是去求概率分布函数\(F(Y<=y)\)),即\(\{g(X)<= y\}\)的等价事件\(\{X \in D_y\}\),从而求出Y的分布函数\(F_Y(y)=P\{Y<=y\}=P\{X \in D_y\}\)。

总之,求随机变量函数的分布问题实质上就是找等价事件的问题。

注意,上面这个技巧非常重要,它是求所有随机变量函数分布的基础,对于离散量的分布很简单,对于连续量的分布时,要深刻注意我们要求的不是\(P(Y=y)\),而是\(F(Y<=y)\)

3.5.2 连续随机变量函数的密度

设X为一连续型随机变量,其概率密度为\(f_X(x)\),随机变量\(Y=g(X)\),若函数\(y=g(x)\)为一严格单调增函数(或减函数),且可微。记\(y=g(x)\)的反函数\(x=h(y)\)。则Y的概率密度为

\[ f_Y(y) = \begin{cases} f_X(h(y))\cdot \lvert h'(y)\rvert,y \in D,\\ 0, y \notin D. \end{cases} \]

其中D为函数y=g(x)的值域

证明:

当\(y=g(x)\)为一严格单调增函数,即\(g'(x)>=0\),注意此时的\(h'(y)>=0\)(注意,只有g(x)为严格的单调增函数时,才有对应的反函数h(y))。而Y的分布函数为

\[ F_Y(y) = P\{Y<=y\} \\ = P\{g(x)<=y\}\\ = P\{X<=h(y)\}\\ = \int_{-\infty}^{h(y)}f_X(x)dx\\ f_Y(y)=F_Y'(y)\\ = f_X(h(y))h'(y) \]

当\(y=g(x)\)为一严格单调减函数,即\(g'(x)<=0\),注意此时的\(h'(y)<=0\)

\[ F_Y(y) = P\{Y<=y\} \\ = P\{g(x)<=y\}\\ = P\{X>=h(y)\}\\ = \int_{h(y)}^{+\infty}f_X(x)dx\\ f_Y(y)=F_Y'(y)\\ = -f_X(h(y))h'(y) \]

所以,综上所述

\[ f_Y(y)= f_X(h(y))\lvert h'(y) \rvert \]

因此得证

这个定理很有用处,他能将连续随机变量分布经过单调随机变量函数后,新连续随机变量轻松地求解出来,相当好用。

从这个定理中,我们可以轻易推导出,当\(X \sim N(\mu,\sigma^2),Y=aX+b\),则\(Y \sim N(a\mu+b,(a\sigma)^2)\)。也就是说,一个正态量的线性函数后仍为正态量。

4 多元随机变量

4.1 多元随机变量

设一随机试验E,其样本空间为\(S=\{e\}\),定义随机变量\(X=X\{e\},Y=Y\{e\}\),称向量\((X,Y)\)为二元随机向量或称二元随机变量。

单元随机变量是研究单个随机变量的演化问题,例如,抛一个骰子,问这个骰子的点数为偶数的概率。而多元随机变量是研究同一时刻多个随机变量的概率问题。例如,同时抛出多个骰子,问这些骰子的点数和为10的概率。而后面我们学到的随机过程则是研究多个时刻同一个随机变量的概率问题,例如,先抛出一个6面骰子,如果这个骰子为偶数,则找一个6面骰子继续抛,否则找一个9面骰子继续抛,不断以此类推,问n次以后这些骰子的点数和为10的概率。

可以看出,随机过程中下一个随机变量的分布是依赖于之前所有随机变量的结果(第二次抛出偶数的概率可能为1/2,也有可能是4/9,要看第一次抛出的结果)。而多元随机变量中,每个随机变量的分布是不依赖于其他随机变量的结果(第二次抛出偶数的概率永远都是1/2,不依赖于其他随机变量,也不跟任意时刻相关)。

另外,要注意的是,同一个问题用不同的角度来考虑,就能用单元随机变量,或多元随机变量,或随机过程来解决。

例如,抛出n个6面骰子,问n个骰子之和为10的概率。令X为n个骰子之和的随机变量。那么根据全概率公式,有:

\[ P(X=10) = P(X=9|第一个骰子为1)\frac 1 6+P(X=8|第一个骰子为2)\frac 1 6+P(X=7|第一个骰子为3)\frac 1 6+\\ P(X=6|第一个骰子为4)\frac 1 6+P(X=5|第一个骰子为5)\frac 1 6+P(X=4|第一个骰子为6)\frac 1 6 \]

如果令\(X_1\)为第一个骰子结果的随机变量,\(X_2\)为第二个骰子结果的随机变量,以此类推,所以我们要求的其实就是\(Y=X_1+X_2+\cdots+X_n\),因此

\[ P(Y=10) = D_n^{10} {(\frac 1 2)}^n \]

D代表n个[1,6]的数的和为10的展开组合数

看,这个问题将用不同角度来看,就能用单元随机变量或多元随机变量的不同工具来解决。

再例如,生男生女的概率都是50% ,如果每家都想要一个男孩,生下一个孩子,如果发现是女孩,当然也要,但是还继续生,直到生下来一个男孩,就满意了,不再生了。那么求只考虑一代的情况下,那么产生的男女比例是多少。设\(S\)为一家中需要生n个孩子的概率,则

\[ P(S=n)=p^{n-1}(1-p) \]

所以,S满足几何分布,因此\(E(S)=\frac 1 p = 2\),又每一家都肯定有一个男孩\(E(男孩)=1\),则\(E(女孩)=E(S)-E(男孩)=1\),因此产生的男女比例是1:1。

换个角度,令\(X_n\)为某一时刻一家中男孩比女孩多的概率。显然,\(X_n\)是\([-\infty,1]\)之间的随机游动的过程,\(X_n\)的停时策略为当往右一步时就停下来,求\(E(X_n)\),这是一个鞅的随机过程。结果为\(E(X_n)=0\),也就是男孩比女孩的期望数量是相同的。

看,再一次地,同一个问题可以用单元随机变量,或随机过程来解决。要注意的是,一般情况下,随机过程的解题能力范围更大,多元随机变量次之,单元随机变量最小,但复杂性也最低。

4.2 离散型多元随机变量

4.2.1 联合分布律

设二元离散量(X,Y)的可能取值为\((x_i,y_i),i,j=1,2,\cdots\),与一元离散量相似,称

\[ P\{X=x_i,Y=y_i\}=p_{ij},i,j=1,2,3,\cdots \]

为(X,Y)的联合概率分布律,或简称联合分布律

注意,联合分布律的本质就是,两个积事件的概率

4.2.2 联合分布律的性质

联合分布律满足:

- \(p_{ij}>=0,i,j=1,2,\cdots\)

- \(\sum\limits_{i}\sum\limits_{j} p_{ij}=1\)

直接套概率定义就可以了,相当直观

4.2.3 二元离散型随机变量

若二元随机变量\((X,Y)\)的取值有限或可列,则称\((X,Y)\)为二元离散型随机变量或称二元离散量

4.2.4 边际分布律

设二元离散量(X,Y)的联合分布律为\(P\{X=x_i,Y=y_i\}=p_{ij},i,j=1,2,\cdots\),故有

\[ P\{X=x_i\}\\ =\sum\limits_{j=1}^{+\infty}P\{X=x_i|Y=y_j\}P\{Y=y_i\}\\ = \sum\limits_{j=1}^{+\infty}P\{X=x_i,Y=y_j\}\\ =\sum\limits_{j=1}^{+\infty}p_{ij}\\ \stackrel{\triangle}{=} p_i,i=1,2,\cdots \]

同样可得

\[ P\{Y=y_j\}=\sum\limits_{i=1}^{\infty}p_{ij}\stackrel{\triangle}{=} p_{\cdot j},j=1,2,\cdots \]

显然有,\(\sum\limits_{i}p_{i \cdot}=1,\sum\limits_{j}p_{\cdot j}=1\),它们分别是随机变量X与Y的概率分布律,分别称为关于X与关于Y的边际分布律或边缘分布律

这个定义相当直观,边际分布律相当于多元导数中的偏微分的思想,固定一端不动,另外一端随便变化。

4.2.5 条件分布律

设二元离散量\((X,Y)\)的联合分布律为

\[ P\{X=x_i,Y=y_j\}=p_{ij},i,j=1,2,\cdots \]

则当$P{Y=y_j} $时

\[ P\{X=x_i\vert Y= y_j\}=\frac {P\{X=x_i,Y=y_j\}} {P\{Y=y_j\}}=\frac {p_{ij}} {p_{\cdot j}},i=1,2,\cdots \]

同理可得,当$P{X=x_i} $时

\[ P\{Y=y_j \vert X=x_i\}=\frac {P\{X=x_i,Y=y_j\}} {P\{X=x_i\}}=\frac {p_{ij}} {p_{i\cdot }},i=1,2,\cdots \]

称上式为给定\(\{Y=y_j\}\)或\(\{X=x_i\}\)的条件下的X或Y的条件分布律

联合分布律是两个积事件的概率,条件分布律则是两个事件之间的条件概率

4.3 多元随机变量的分布函数

4.3.1 联合分布函数

设二元随机变量(X,Y),对于任意的实数x,y,称函数

\[ F(x,y)=P\{X<=x,Y<=y\} \]

为(X,Y)的联合分布函数

很明显,这个定义是单元概率分布函数在二元上的推广

4.3.2 联合分布函数的性质

联合分布函数F(x,y)有以下的性质

- 当给定\(x=x_0\)时,\(F(x_0,y)\)关于y单调不减;当给定\(y=y_0\)时,\(F(x,y_0)\)关于x单调不减。

- \(0<=F(x,y)<=1\),且\(F(x,-\infty)=F(-\infty,y)=F(-\infty,-\infty)=0,F(+\infty,+\infty)=1\)

- \(F(x,y)=F(x+0,y);F(x,y)=F(x,y+0)\),即F(x,y)关于x右连续,关于y右连续

- 当实数\(x_2>x_1,y_2>y_1\)时,\(P\{x_1<X<=x_2,y_1<Y<=y_2\}=F(x_2,y_2)-F(x_1,y_2)-F(x_2,y_1)+F(x_1,x_1)\)

前三个都是很显然的,我们证明一下第四点

先设

\[ A=\{X<=x_2,Y<=y_2\}\\ B=\{X<=x_1,Y<=y_2\}\\ C=\{X<=x_2,Y<=y_1\}\\ \]

那么

\[ P\{x_1<X<=x_2,y_1<Y<=y_2\}\\ = P\{A-B\cup C\}\\ = P\{A\}-P\{A(B \cup C)\}\\ = P\{A\}-P\{B \cup C\}\\ = P\{A\}-P\{B\}-P\{C\}+P\{BC\}\\ =F(x_2,y_2)-F(x_1,y_2)-F(x_2,y_1)+F(x_1,x_1) \]

所以得证

4.3.3 边缘分布函数

设二元变量(X,Y)的联合分布函数为F(x,y),X,Y的边际分布函数为\(F_X(x),F_Y(y)\),则

\[ F_X(x)=P\{X<=x\}=P\{X<=x,Y<+\infty\}=F(x,+\infty) \]

同理,\(F_Y(y)=F(+\infty,y)\)。即,二元随机变量的边际分布函数就是固定其中一个,而另外是取遍所有可能的概率,注意边际分布律与边际分布函数是不一样的,边际分布函数是\(P\{X<=x,Y<+\infty\}\),边际分布律是\(P\{X=x,Y<+\infty\}\)

4.3.4 条件分布函数

设(x,y)为二元离散量,当\(P\{X=x_i\} \neq 0\)时,称函数

\[ F_{Y \vert X}(y \vert x_i) = P\{Y<=y \vert x=x_i\} \]

为\(\{X=x_i\}\)条件下的条件分布函数

设(x,y)为二元连续量,当任意固定\(\delta >0\),\(P\{x<X<=x+\delta\}>0\)时,称函数

\[ F_{Y \vert X}(y \vert x)=\lim\limits_{\delta \to 0^+}P\{Y<=y \vert x < X <= x+\delta\} \]

为\(\{X=x\}\)条件下Y的条件分布函数。

要特别注意,条件分布函数与条件分布律是不一样的,这个不同点和边际分布律与边际分布函数的不同点是一样的。另外,边际分布是,任取y,取x的概率。条件分布是,固定y,取x的概率,两者也是不一样的。

4.4 连续型多元随机变量

4.4.1 二元连续型随机变量

设(X,Y)为二元随机变量,若存在二元函数f(x,y)>=0,对任意的二维空间的集合D,有

\[ P\{(X,Y)\in D\}=\iint_{D} f(x,y)dxdy \]

则称(X,Y)为二元连续型随机变量,简称二元连续量,称f(x,y)为(X,Y)的联合概率密度,简称联合密度

显然,跟一元连续量的类似,二元连续量落在任意一点,或任意一条直线的概率都为0.

4.4.2 联合密度函数

联合概率密度函数f(x,y)具有以下的性质

- \(f(x,y)>=0\)

- \(F(x,y)=\int_{-\infty}^{x} \int_{-\infty}^y f(u,v)dvdu\)

- \(\int_{-\infty}^{+\infty} \int_{-\infty}^{+\infty} f(x,y)dydx = F(+\infty,+\infty)=1\)

- 在f(x,y)的连续点上有,\(\frac {\partial^2 F(x,y)}{\partial x \partial y} = f(x,y)\)

4.4.3 边际密度函数

设(X,Y)为二元连续量,F(x,y),f(x,y)分别为(X,Y)的联合分布函数及联合密度函数,称单个随机变量X(或Y)的密度函数为X(或Y)的边际密度函数,且常分别用\(f_X(x),f_Y(y)\)表示。由于

\[ P\{X \in D\}=P\{X \in D , Y \in (-\infty,+\infty)\}=\int_D[\int_{-\infty}^{+\infty}f(x,y)dy]dx \]

那么根据由连续型随机变量的定义知,X为连续量,且X的概率密度函数为

\[ f_X(x) = \int_{-\infty}^{+\infty}f(x,y)dy\\ f_Y(y) = \int_{-\infty}^{+\infty}f(x,y)dx \]

即边际密度为联合密度关于另外一个变量在\((-\infty,+\infty)\)上的积分。

注意,边际密度不要将其理解为另外一个变量在\((-\infty,+\infty)\)上的积分,这样会丢失边际密度的核心意义。边际密度本质是其中一个随机变量的分布函数的导数,我们是需要关注定义域的,不能简单理解为\((-\infty,+\infty)\)的积分。例如

\[ f(x,y) = \begin{cases} \frac {1} {x},0<y<x<1,\\ 0,其他 \end{cases} \]

注意,定义域中y与x的关系。那么

\[ F(x,+\infty) = \int_{-\infty}^{x}dx\int_{-\infty}^{+\infty} f(x,y)dy\\ = \int_{0}^{x} dx \int_{0}^{x} \frac {1} {x} dy\\ = \int_{0}^{x}dx \left.\frac {y} {x} \right\vert_{0}^{x}\\ = \int_{0}^{x} 1 dx \]

因此

\[ f(x,+\infty) = 1\\ f_X(x) = 1 \]

如果,我们忽略了定义域的关系,我们就会得出以下的一个错误的结论

\[ f_X(x) = \int_{-\infty}^{+\infty}\frac 1 x dy\\ = \int_{0}^{1} \frac 1 x dy\\ = \left. \frac y x \right\vert_{0}^{1}\\ = \frac {1} {x} \]

而显然,对于\(x \in [0,1],\int_{0}^{1} f_X(x)dx\)的概率和不为1,也就是边际密度的概率和不为1,因此下面的推导方式是错误的!

4.4.4 条件密度函数

设(X,Y)为二元连续量,f(x,y)为(X,Y)的联合密度函数,\(f_X(x),f_Y(y)\)为X,Y的边际密度函数,给定\(\{X=x\}\)的条件下,Y的条件密度函数为

\[ f_{Y \vert X}(y \vert x) = \frac {f(x,y)} {f_X(x)},f_X(x) \neq 0 \]

同样有

\[ f_{X \vert Y}(x \vert y) = \frac {f(x,y)} {f_Y(y)},f_Y(y) \neq 0 \]

证明:

\[ F_{Y\vert X}(y \vert x) = \lim\limits_{\delta \to 0^+} P\{Y<=y \vert x < X <= x+ \delta\}\\ =\lim\limits_{\delta \to 0^+} \frac {P\{x<X<=x+\delta,Y<=y\}} {P\{x<X<=x+\delta\}}\\ =\lim\limits_{\delta \to 0^+} \frac {F(x+\delta,y)-F(x,y)} {F_X(x+\delta)-F_X(x)}\\ =\lim\limits_{\delta \to 0^+} \frac {[F(x+\delta,y)-F(x,y)]/\delta} {[F_X(x+\delta)-F_X(x)]/\delta}\\ =\frac {\lim\limits_{\delta \to 0^+}[F(x+\delta,y)-F(x,y)]/\delta}{\lim\limits_{\delta \to 0^+}[F_X(x+\delta)-F_X(x)]/\delta} \]

又

\[ \lim\limits_{\delta \to 0^+}[F(x+\delta,y)-F(x,y)]/\delta \\ = \frac {\partial F(x,y)} {\partial x}\\ = \frac {\int_{-\infty}^{x}{\int_{-\infty}^{y} f(u,v)dv}du} {\partial x}\\ = \int_{-\infty}^{y} f(u,v)dv \]

\[ \lim\limits_{\delta \to 0^+}[F_X(x+\delta)-F_X(x)]/\delta\\ = f_X(x) \]

因此

\[ F_{Y\vert X}(y \vert x) = \frac {\int_{-\infty}^{y} f(u,v)dv} {f_X(x)}\\ F'_{Y\vert X}(y \vert x)= \frac {f(x,y)} {f_X(x)} \]

故得证

从定义和证明的过程中可以看到,条件概率密度函数的形式和离散量条件分布律的形式很相似。其实很多情况下,离散量下的概率就相当于连续量下的密度

显然,条件密度函数具有以下的性质

- \(f_{Y\vert X}(y \vert x) >= 0\)

- \(F_{Y \vert X}(y \vert x) = P\{Y<=y \vert X = x\} = \int_{-\infty}^{y} f_{Y\vert X}(v \vert x)dv\)

- \(\int_{-\infty}^{+\infty}f_{Y \vert X}(y \vert x)dy= 1\)

- 给定x,当\(f_{Y \vert X}(y \vert x)\)在y处连续时,\(\frac {d F_{Y \vert X}(y \vert x) } {dy} = f_{Y \vert X}(y \vert x)\)

4.4.5 均匀分布

设二元随机变量(X,Y)在二维有界区域D上取值,且具有联合概率密度

\[ f(x,y) = \begin{cases} \frac {1} {D的面积},(x,y) \in D,\\ 0,其他 \end{cases} \]

则称(X,Y)服从D上的均匀分布

相当直接和简单,是一元的均匀分布的推广

4.4.6 二元正态分布

设二元随机变量(X,Y)具有联合概率密度

\[ f(x,y) = \frac {1} {2\pi\sigma_1\sigma_2\sqrt{1-\rho^2}}exp\{-\frac {1} {2(1-\rho^2)}[\frac {(x -\mu_1)^2}{\sigma_1^2}-2\rho\frac {(x-\mu_1)(y-\mu_2)} {\sigma_1\sigma_2}+\frac {(y-\mu_2)^2}{\sigma_2^2}]\} \]

其中\(\lvert \mu_1 \rvert < +\infty,\lvert u_2 \rvert < +\infty,\sigma_1>0,\sigma_2>0,\lvert \rho \rvert < 1\),则称(X,Y)服从参数为\((\mu_1,\mu_2,\sigma_1^2,\sigma_2^2,\rho)\)的二元正态分布,记为\((X,Y) \sim N(\mu_1,\mu_2,\sigma_1^2,\sigma_2^2,\rho)\)

4.5 多元随机变量的独立性

4.5.1 二元随机变量的相互独立性

对于任意两个实数集合\(D_1,D_2\),有

\[ P\{X \in D_1,Y \in D_2\}= P\{X \in D_1\}\cdot P\{Y \in D_2\} \]

则称随机变量X,Y相互独立,简称X,Y独立

这个定义的等价定义是,随机变量X,Y相互独立,当且仅当对任意实数x,y,有

\[ F(x,y) = F_X(x)\cdot F_Y(y) \]

特别地,当随机变量X,Y都是离散量时,随机变量X,Y相互独立的条件为,对任意的实数\(x_i,y_j\),都有

\[ p_{ij} = p_{i\cdot}\cdot p_{\cdot j},i,j=1,2,\cdots \]

当随机变量X,Y都是连续量时,随机变量X,Y相互独立的条件为,对任意的x,y,都有

\[ f(x,y)= f_X(x) \cdot f_Y(y) \]

这个定义是从概率的分布的角度来描述究竟两个随机变量是否为相互独立的。一般情况下,套这里下面的两条公式就能看到了。

4.5.2 独立性与联合密度函数

二元连续量X,Y相互独立的充要条件是X,Y的联合密度f(x,y)几乎处处可写成x的函数m(x)与y的函数n(y)的乘积,即

\[ f(x,y) = m(x) \cdot n(y) ,\lvert x \rvert < +\infty , \lvert y \rvert < +\infty \]

直接套连续量相互独立的条件就可以了,不难。

注意,这个定理相当容易被乱使用,要注意的是定理中处处的要求。例如,

\[ f(x,y) = \begin{cases} e^{-x}/2,x>0,0<y<2,\\ 0,其他\\ \end{cases} \]

将\(m(x)\)看成是\(e^{-x}/2\),\(n(y)\)看成是1,所以X,Y是独立,这样是没有问题的。

\[ f(x,y) = \begin{cases} 1/x,0<y<x<1\\ 0,其他\\ \end{cases} \]

因此,我们依样画葫芦,认为\(m(x)\)看成是\(1/x\),\(n(y)\)看成是1,所以认为X,Y是相互独立的,可这样推算是错误的!!!

因为,对于\(0<x<y<1\)的区域,概率密度为0。但是套我们\(m(x)\)与\(n(y)\)的公式,在\(0<x<y<1\)的区域,\(m(x)=1/x\)不为0,\(n(y)=1\)也为0,两者相乘的概率根本不可能为0。也就是有很大的一片区域中,\(f(x,y) \neq m(x)n(y)\),因此X,Y不是相互独立的。

这个定理相当容易被误用,更好的办法还应该老实地算出\(f_X(x)\)与\(f_Y(y)\),看一看两者相乘是否为f(x,y)更为可靠

4.6 多元随机变量函数

4.6.1 二元随机变量函数的分布

二元随机变量函数,就是在已知X,Y的分布函数情况,求Z=g(X,Y)的分布函数,这种计算的规律跟一元的随机变量函数分布类似,就不多说了,关键还是在寻找等价事件上。

4.6.2 Z=X+Y

已知X,Y的概率分布,求\(Z=X+Y\)的概率分布。若(X,Y)为二元离散量,设\(P\{X=x_i,Y=y_j\}=p_{ij}\),设Z的可能取值为\(z_1,z_2,\cdots,z_k,\cdots\),则显然有

\[ P\{Z=z_k\} = P\{X+Y=z_k\}=\sum\limits_{i=1}^{+\infty}P\{X=x_i,Y=z_k-x_i\},k=1,2,\cdots\\ P\{Z=z_k\} = P\{X+Y=z_k\}=\sum\limits_{j=1}^{+\infty}P\{X=z_k-y_j,Y=y_j\},k=1,2,\cdots\\ \]

若(X,Y)为二元连续量,设联合密度为f(x,y),则Z的密度函数为

\[ f_Z(z) = \int_{-\infty}^{+\infty}f(x,z-x)dx\\ f_Z(z) = \int_{-\infty}^{+\infty}f(z-y,y)dy\\ \]

证明:

离散的证明很简单,我们来证明一下连续量的

\[ F_Z(z) = P\{Z <= z\}\\ = P\{X+Y<=z\}\\ = \iint_{X+Y<=z}f(x,y)dxdy\\ = \int_{0}^{+\infty}dx \int_{0}^{z-x}f(x,y)dy \]

作积分变换\(u=x,v=x+y\),因此

\[ F_Z(z) = \int_{ -\infty}^{+\infty}dx \int_{0}^{z-x}f(x,y)dy\\ = \int_{-\infty}^{z}dv \int_{-\infty}^{+\infty} f(u,v-u)du\\ = \int_{-\infty}^{z}dv \int_{-\infty}^{+\infty} f(u,z-u)du\\ f_Z(z) = F_Z'(z) = \int_{-\infty}^{+\infty} f(u,z-u)du = \int_{-\infty}^{+\infty} f(x,z-x)dx \]

所以得证

再一次地,离散量的公式和连续量的公式都是概率与密度的形式相似

4.6.3 M=max(X,Y),N=min(X,y)

设X,Y为两个随机变量,它们的联合分布函数为\(F(x,y)\),记\(M=max(X,Y),N=min(X,Y)\),则有

\[ F_M(t) = F(t,t)\\ F_N(t) = F_X(t)+F_Y(t)-F(t,t)\\ \]

证明:

\[ F_M(t) = P\{max(X,Y)<=t\}\\ = P\{X<=t,Y<=t\}\\ = F(t,t)\\ \]

\[ F_N(t) = P\{min(X,Y)<=t\}\\ = P\{(X<=t) \cup (Y<=t)\}\\ = P\{X<=t\} + P\{Y<=t\} - P\{x<=t,y<=t\}\\ = F_X(t)+F_Y(t)-F(t,t)\\ \]

所以得证

4.6.4 常见分布的随机变量函数分布

- 相互独立的泊松分布随机变量和仍然为泊松分布,\(X \sim \pi(\lambda_1),Y \sim \pi(\lambda_2),X+Y \sim \pi(\lambda_1,\lambda_2)\)

- 相互独立的正态分布随机变量和仍然为正态分布,\(X \sim N(\mu_1,\sigma_1^2),Y \sim N(\mu_2,\sigma_2^2),X+Y \sim N(\mu_1+\mu_2,\sigma_1^2+\sigma_2^2)\)

5 随机变量的数字特征

5.1 数学期望

5.1.1 随机变量的数学期望

随机变量的数学期望又称平均数。

设离散型随机变量X的分布律为

\[ P(X=x_i)=p_i,i=1,2,\cdots \]

若级数\(\sum\limits_{i=1}^{+\infty}x_ip_i\)绝对收敛,则称级数\(\sum\limits_{i=1}^{+\infty}x_ip_i\)为X的数学期望,记为\(E(x)\),即

\[ E(X) = \sum\limits_{i=1}^{+\infty} x_ip_i \]

设离散型随机变量X的密度函数为f(x),若\(\int_{-\infty}^{+\infty} \lvert x \rvert f(x)dx <\infty\),则称积分\(\int_{-\infty}^{+\infty} x f(x)dx\)为X的数学期望,记为E(X),即

\[ E(X) = \int_{-\infty}^{+\infty}xf(x)dx \]

若\(\int_{-\infty}^{+\infty} \lvert x \rvert f(x)dx = +\infty\),则称随机变量X的数学期望不存在。

从定义可以看出,数学期望其实就是函数值的概率权重之和。对于离散型随机变量而言,这个权重是概率,对于连续型随机变量而已,这个权重是概率密度。另外,数学期望存在的条件是绝对收敛,因为不是绝对收敛的级数在调整次序而已数学期望是不一样的,但是从直观而言,我们要求数学期望是跟级数的次序无关的。因此无论是离散型随机变量,还是连续型随机变量,都是要求绝对收敛的。

从直观来看,数学期望是概率分布在长期试验中趋向的值。例如,买大得10元,买小亏5元,长期来看你每场盈利的数学期望为\(E(X)=0.5*10+0.5*(-5)=2.5\)

5.1.2 数学期望与概率分布函数

若随机变量X的分布函数为F(x),则

\[ E(X) = \int_{0}^{+\infty}(1-F(x))dx-\int_{-\infty}^{0} F(x)dx \]

特别地,当X为非负随机变量(即P(X>=0)=1)时,有

\[ E(X) = \int_{0}^{+\infty}(1-F(x))dx \]

当X为取非负整数值的随机变量时,有

\[ E(X) = \sum_{k=1}^{+\infty}P(X>=k) \]

证明略,需要用到斯蒂尔杰斯积分的计算=,=

这个定理相当神奇,因为\(F(x)\)中已经每一点中对应的概率信息,所以使用\(F(x)\)能完整推导出\(E(x)\)的信息出来,这是一个沟通数学期望与概率分布函数的公式,偶尔会有化腐朽为神奇的能力。

5.1.3 随机变量函数的数学期望

当X为离散型随机变量时,若\(\sum\limits_{i=1}^{+\infty} \lvert g(x_i) \rvert p_i < +\infty\),则\(g(X)\)的数学期望\(E(g(X))\)存在,且

\[ E(g(X))=\sum\limits_{i=1}^{+\infty}g(x_i)p_i \]

其中\(P(X=x_i)=p_i,i=1,2,\cdots\)为X的分布律

当X为连续型随机变量时,若\(\int_{-\infty}^{+\infty}\lvert g(x) \rvert f(x)dx < +\infty\),则\(g(X)\)的数学期望\(E(g(X))\)存在,且

\[ E(g(X)) = \int_{-\infty}^{+\infty}g(x)f(x)dx \]

其中f(x)为X的概率密度函数

证明:

离散型随机变量还是很明显的,我们证明一下连续型随机变量的情况。因为Y=g(X),设Y的概率密度为

\[ h(y) = f(g^{-1}(y))[g^{-1}(y)]'\\ = f(g^{-1}(y))\frac {1} {g'(x)}\\ \]

因此

\[ E(Y) = \int_{-\infty}^{+\infty}yh(y)dy\\ = \int_{-\infty}^{+\infty} yf(g^{-1}(y))\frac {1} {g'(x)}dy\\ =\int_{-\infty}^{+\infty} g(x)f(g^{-1}(g(x)))\frac {1} {g'(x)}dg(x)\\ =\int_{-\infty}^{+\infty} g(x)f(x)dx \]

所以得证

这个定理可以简化解决随机变量函数的数学期望的计算问题

5.1.4 随机变量线性组合的数学期望

若n个随机变量,\(X_1,X_2,\cdots,X_n\)的期望都存在,则对任意\(n+1\)个实数\(c_0,c_1,c_2,\cdots,c_n\),\(c_0+\sum\limits_{i=1}^{n}c_iX_i\)的期望存在,且

\[ E(c_0+\sum\limits_{i=1}^{n}c_iX_i)=c_0+\sum\limits_{i=1}^{n}c_iE(X_i) \]

证明:

当\(X,Y\)的期望存在时,\(E(X+Y)=E(X)+E(Y)\),因为

\[ E(X+Y)=\iint_{D} (x+y)f(x,y)dxdy\\ =\iint_{D} xf(x,y)dxdy+\iint_{D} yf(x,y)dxdy\\ =\int_{-\infty}^{+\infty}xdx\int_{-\infty}^{+\infty} f(x,y)dy+\int_{-\infty}^{+\infty}ydy\int_{-\infty}^{+\infty} f(x,y)dx\\ =\int_{-\infty}^{+\infty}xf_X(x)dx+\int_{-\infty}^{+\infty}yf_Y(y)dy\\ = E(X)+E(Y) \]

对于更高元的随机变量,这个结论也成立。然后,对于线性组合的期望,期望值也是对应的随机变量的线性组合(随机变量函数的期望计算)。因此,结论得证。

注意,这个定理相当有用,对于两个随机变量是独立,还是不独立,这个定理都能使用。

5.1.5 独立随机变量乘积的数学期望

n个相互独立随机变量的乘积的期望等于它们期望的乘积。即若随机变量\(X_1,X_2,\cdots,X_n\)相互独立,期望都存在,则\(\prod\limits_{i=1}^{n}X_i\)的期望也存在,且

\[ E(\prod\limits_{i=1}^{n}X_i) = \prod\limits_{i=1}^{n}E(X_i) \]

这个证明相当简单,直接套连续量的期望定义就可以了。

注意,这个定理只对相互独立的随机变量有效。

5.1.6 条件数学期望

若(X,Y)为二维离散型随机变量,且在给定X=x下,Y的条件分布律为\(P\{Y=y_i\vert X=x\}=p_j(x),j=1,2,\cdots\),或者(X,Y)为二维连续型随机变量,在给定\(\{X=x\}\)下,Y的条件概率密度函数为\(f_{Y\vert X}(y \vert x)\),则在给定了随机变量X取值为x的条件下,Y的条件期望为

\[ E(Y\vert X = x) = \begin{cases} \sum\limits_{j=1}^{+\infty} y_jp_j(x),(X,Y)为离散型随机变量\\ \int_{-\infty}^{+\infty} y f_{Y \vert X}(y\vert x)dy,(X,Y)为连续型随机变量\\ \end{cases} \]

有时也简记为\(E(Y \vert x)\)

条件数学期望就是指在已知发生x事件的条件下,求Y的数学期望,就是在缩小了状态空间下的数学期望而已。

5.1.7 全数学期望公式

(X,Y)为二维随机变量,若存在,则

\[ E(Y) = E[E(Y \vert X)] \]

这被称为全数学期望公式。

特别地,当(X,Y)为二维离散型随机变量时,这个公式为:

\[ E(Y) = \sum_{i=1}^{+\infty}E(Y \vert X = x_i)\cdot P\{X=x_i\} \]

其中\(x_i,i=1,2,\cdots\)为X的所有可能取值

直接套数学期望的定义,和概率的积公式就可以证明了

5.1.8 常见分布的数学期望

离散型随机变量

- \(X \sim B(1,p),E(X)=p\)

- \(X \sim \pi(\lambda),E(X)=\lambda\)

- \(X \sim B(n,p),E(X) = np\)

- \(X \sim Geo(p),E(X) = \frac 1 p\)

连续型随机变量

- \(X \sim U(a,b),E(X) = \frac {a+b} {2}\)

- \(X \sim N(\mu,\sigma^2),E(X)=\mu\)

- \(X \sim E(\lambda),E(X) = \frac 1 \lambda\)

5.2 方差

5.2.1 方差

设随机变量X的数学期望存在,若\(E(X-E(X))^2\)存在,则称\(E(X-E(X))^2\)为X的方差,记为D(X)或Var(X)。方差的平方根\(\sqrt{D(X)}\)称为随机变量X的标准差或均方差,记为SD(X)。

从定义可以看出,方差描述了随机变量X的取值与其中心位置——数学期望的平均偏离程度,标准差则与方差一样的用法,它只是与数学期望具有相同量纲而已。并且从定义可以看出,方差仅仅只是新随机变量的数学期望的一种特殊情况而已。

若离散型随机变量X的分布律为\(P(X=x_i)=p_i,i=1,2,\cdots\),则X的方差为

\[ D(X) = \sum\limits_{i=1}^{+\infty}(x_i-E(X))^2p_i \]

若连续型随机变量X的密度函数为f(x),则X的方差为

\[ D(X) = \int_{-\infty}^{+\infty}(x-E(X))^2f(x)dx \]

从直观来看,方差是概率分布在长期试验中趋向与数学期望的差值平方。例如,买大得10元,买小亏5元,长期来看你每场距离数学期望的差值平方为\(D(X)=0.5*(10-2.5)^2+0.5*(-5-2.5)^2=56.25,\sqrt{D(X)}=7.5\),注意,这里是说每场距离数学期望的差值,而不是离总体数学期望的差值。可以被证明,总体方差是更小的。

5.2.2 方差与数学期望

若随机变量X的方差存在,则

\[ D(X) = E(X^2)-(E(X))^2 \]

证明:

\[ D(X) = E((X-E(X))^2)\\ = E(X^2-2XE(X) + (E(X))^2)\\ = E(X^2)-2E(X)E(X) + (E(X))^2\\ = E(X^2)-(E(X))^2 \]

所以得证

这个定理是推算方差的常用公式

5.2.3 方差的性质

设随机变量X的方差存在,c为某一常数,则

- \(D(cX)=c^2D(X)\)

- \(D(X+c)=D(X)\)

- \(D(X)<=E((X-c)^2)\)

证明:

\[ D(cX) = E((cX-E(cX))^2)\\ = E(c^2(X-E(X))^2)\\ = c^2E((X-E(X)^2))\\ = c^2D(X) \]

证得第一个

\[ D(X+c) = E((X+c-E(X+c))^2)\\ = E((X+c-(E(X)+c))^2)\\ = E((X-E(X))^2)\\ = D(X) \]

证得第二个

\[ D(X) = E(X^2)-(E(X))^2\\ D(X) <= E(X^2),仅当E(X)=0等号成立\\ D(X-c) <= E((X-c)^2),仅当E(X-c)=0等号成立\\ D(X) <= E((X-c)^2),仅当E(X-c)=0等号成立 \]

因此第三个成立,当且仅当E(X)=c成立

5.2.4 零方差定理

设随机变量X的方差存在,则D(X)=0,当且仅当P(X=c)=1,其中c=E(X)

这是显然的

5.2.5 独立随机变量线性组合的方差

对任意的正整数n>=2,设\(X_1,X_2,\cdots,X_n\)为两两独立的随机变量,方差都存在。则对任意的有限实数\(c_0,c_1,c_2,\cdots,c_n\),\(c_0+\sum\limits_{i=1}^{n}c_iX_i\)的方差也存在,且

\[ D(c_0+\sum\limits_{i=1}^{n}c_iX_i)=\sum\limits_{i=1}^{n}c_i^2D(X_i) \]

证明:

\[ D(\sum\limits_{i=1}^{n}c_iXi)\\ = E((\sum\limits_{i=1}^{n}c_iX_i-E(\sum\limits_{i=1}^{n}c_iX_i))^2)\\ = E((\sum\limits_{i=1}^{n}c_iX_i-\sum\limits_{i=1}^{n}c_iE(X_i))^2)\\ = E([\sum\limits_{i=1}^{n}(c_iX_i-c_iE(X_i))]^2)\\ = \sum\limits_{i=1}^{n}E([c_iX_i-c_iE(X_i)]^2)+2\sum\limits_{1<=i<j<=n}E[(X_i-E(X_i))(X_j-E(X_j))]\\ = \sum\limits_{i=1}^{n}D(c_iX_i)\\ = \sum\limits_{i=1}^{n}c_i^2D(X_i)\\ \]

前面的偏移量\(c_0\)则根据方差的性质可以直接消除掉,因此得证

注意,这个定理很有可用,它描述了任意多个独立的随机变量的线性组合的方差。这个定理是经济学中资产配置的理论基础。设每个股票市场都是服从每年增长率服从\(E(X)=1.1,D(X)=10\)的分布,如果我将钱平均购买10个市场,而不只买1个市场,那么

\[ E(\sum\limits_{i=1}^{10}\frac {1} {10} X) = \sum\limits_{i=1}^{10} \frac {1} {10} E(X) = E(X) = 1.1\\ D(\sum\limits_{i=1}^{10}\frac {1} {10} X) = \sum\limits_{i=1}^{10} \frac {1} {10^2} D(X) = \frac {1} {10} D(X) = 1 \]

也就是说在假设10个市场都是独立的情况下,分散投资能在不改变期望的情况下降低方差,也就是降低整体投资亏损风险,这就是分散投资的理论基础。

如果市场是相关的,而不是独立的呢,那么后面我们会说到协方差的算法,将会继续讨论。注意到,这个定理只对相互独立的随机变量有效,不像数学期望关于线性组合的随机变量公式不限于相互独立的随机变量。

5.2.6 标准化变量

若随机变量X的方差存在,那么称

\[ X^* = \frac {X-E(X)} {\sqrt{D(X)}} \]

为X的标准化随机变量。

这所以叫做标准化随机变量,是因为经过这样变换后,任意的随机变量都会变成\(E(X^*)=0,D(X^*)=1\)的变量,这样就能方便不同量纲的随机变量的比较了。

5.2.7 变异系数

若随机变量X的方差存在,那么称

\[ C_v = \frac {\sqrt{D(X)}} {E(X)} \]

为X的变异系数

这个叫变异系数,是为了解决将不同量纲的随机变量进行方差比较。

5.2.8 常见分布的方差

离散型随机变量

- \(X \sim B(1,p),D(X)=p(1-p)\)

- \(X \sim \pi(\lambda),D(X)=\lambda\)

- \(X \sim B(n,p),D(X) = np(1-p)\)

- \(X \sim Geo(p),D(X) = \frac {1-p} {p^2}\)

连续型随机变量

- \(X \sim U(a,b),D(X) = \frac {(b-a)^2} {12}\)

- \(X \sim N(\mu,\sigma^2),D(X)=\sigma^2\)

- \(X \sim E(\lambda),D(X) = \frac 1 {\lambda^2}\)

5.3 协方差

5.3.1 协方差

对于期望都存在的随机变量X和Y,当(X-E(X))(Y-E(Y))的期望都存在时,称

\[ Cov(X,Y) = E\{(X-E(X))(Y-E(Y))\} \]

若二元离散型随机变量(X,Y)的联合分布律为\(P(X=x_i,Y=y_j)=p_{ij},i=1,2,\cdots,j=1,2,\cdots\),则X与Y的协方差为

\[ Cov(X,Y) = \sum\limits_{i=1}^{+\infty} \sum\limits_{j=1}^{+\infty} (x_i-E(X))(y_j-E(Y))p_{ij} \]

若二元连续型随机变量(X,Y)的联合密度函数为f(x,y),则X与Y的协方差为

\[ Cov(X,Y) = \int_{-\infty}^{+\infty}\int_{-\infty}^{+\infty}(x-E(X))(y-E(Y))f(x,y)dxdy \]

从定义可以看出,协方差是联合分布中两个变量与各自期望的乘积期望。从直观来看,如果两个变量是线性无关的,那么两个变量之间中的同时都大和同时都小的概率,与一大一小和一小一大的概率应该是相等的。也就说,如果有联合分布中,有一半都是同时大同时小,另外一半都是半大半小的话,则我们认为它们之间是没有线性相关性的。

所以,协方差描述了两个变量的线性相关性,如果协方差为0,则这两个变量是没有线性相关性的。如果协方差大于0,且数值较大,则这两个变量是正相关性的,否则就是负相关的。

要注意的是,协方差只描述了两个变量的线性相关性,但没有完全描述是否相互独立性。也就是说,两个变量是相互独立的,那它肯定是线性无关的,如果两个变量线性无关,则它不一定是相互独立的。变量是否为独立的,归根到底还得看联合分布函数是否为两个边际分布函数的乘积。

5.3.2 协方差与数学期望

对于随机变量X,Y,这两个随机变量的协方差为:

\[ Cov(X,Y) = E(XY)-E(X)E(Y) \]

证明:

\[ Cov(X,Y)=E((X-E(X)(Y-E(Y))\\ =E(XY-XE(Y)-E(X)Y+E(X)E(Y))\\ =E(XY)-E(X)E(Y)-E(X)E(Y)+E(X)E(Y)\\ =E(XY)-E(X)E(Y)\\ \]

所以得证

5.3.3 随机变量线性组合的方差

对任意的正整数n>=2,设\(X_1,X_2,\cdots,X_n\)为方差存在的随机变量。则\(X_1+X_2+\cdots+X_n\)的方差也存在,且

\[ D(\sum\limits_{i=1}^{n}X_i) = \sum\limits_{i=1}^{n}D(X_i) + 2 \sum\limits_{1<=i<j<=n}Cov(X_i,X_j) \]

这个定理,在独立随机变量线性组合的方差时就已经间接推导过了,所以就不多说了。这个定理完整地说明了对于不独立的随机变量,它们的方差究竟是什么。

从这个定理中我们也能推导出,如果只有两个投资标的可以选择的话,我们应该选择两个市场是最大负相关的,这样的话合起来的投资组合才是方差最小的。但是,如果我们需要投资两个以上的投资标的时,我们应该选择投资标的中相关性最低的。因为,如果我们选两个标的是最大负相关的,第三个标的肯定与第一个或第二个是正相关的,这样会大幅增加投资组合的方差。所以,组建投资组合时,最重要的一点是,它们都必须是最低相关性的。

5.3.4 协方差的性质

若随机变量X和Y的协方差存在,则

- \(Cov(X,Y)=Cov(Y,X)\)

- \(Cov(X,X)=D(X)\)

- \(Cov(aX,bY)=ab\cdot Cov(X,Y)\),其中a,b为两个实数

- 若\(Cov(X_i,Y)(i=1,2)\)的协方差存在,则\(Cov(X_1+X_2,Y)=Cov(X_1,Y)+Cov(X_2,Y)\)

- 若X和Y独立,则\(Cov(X,Y)=0\),但反之则不然

- 当\(D(X)\cdot D(Y) \neq 0\)时,有\((Cov(X,Y))^2<=D(X)D(Y)\),其中等式成立当且仅当X与Y之间有严格的线性关系。

前五点都比较容易证明,第六点证明略,第六点说明了协方差与方差存在不等式的关系

5.3.5 相关系数

对于随机变量X和Y,当\(E(X^2)\)与\(E(Y^2)\)均存在且\(D(X),D(Y)\)均为非零实数时,称

\[ \rho_{XY} = \frac {Cov(X,Y)} {\sqrt{D(X)}\sqrt{D(Y)}} \]

为X与Y的相关系数,也简记为\(\rho\)

从协方差性质中可以看出,\(Cov(X,Y)^2<D(X)D(Y)\),也就是说相关系数\(\rho\)总是在[-1,1]的之间,这个统计值能很好地比较不同随机变量之间的相关性

5.3.6 相关系数与独立

对于随机变量X和Y,当相关系数\(\rho_{XY}\)存在时,有

- 若X和Y独立,则\(\rho_{XY}=0\),但反之不然

- \(\lvert \rho_{XY} \rvert <= 1\),其中等号成立当且仅当X和Y之间有严格的线性关系。即存在常数\(c_1,c_2\)使得\(P(Y=c_1+c_2X)=1\)成立

5.4 其他数字特征

5.4.1 矩

设X,Y为随机变量,k,l为正整数,如果以下的数学期望都存在,则称

\[ \mu_k=E(X^k) \]

为X的k阶原点矩。称

\[ v_k=E[X-E(X)]^k \]

为X的k阶中心矩。称

\[ E(X^kY^l) \]

为X和Y的k+l阶混合原点矩。称

\[ E[(X-E(X))^k(Y-E(Y))^l] \]

为X和Y的k+l阶混合中心矩

显然,矩是期望,方差,协方差的多阶推广

5.4.2 分位数

设连续型随机变量的分布函数和密度函数分别为F(x)和f(x),对任意的\(0<\alpha<1\),称满足条件

\[ 1-F(x_\alpha)=\int_{x_\alpha}^{+\infty} f(x)dx=\alpha \]

的实数\(x_\alpha\)为随机变量X的上\(\alpha\)分位数

注意分位数是上份位

5.4.3 众数

随机变量X最有可能取的数值,称为众数,记为Mo(X)

注意,众数不一定具有唯一性。

5.5 多元随机变量的数字特征

5.5.1 多元数学期望

记n元随机变量为\(X=(X_1,X_2,\cdots,X_n)'\),若其每一分量的数学期望都存在,则称

\[ E(X) = (E(X_1),E(X_2),\cdots,E(X_n))' \]

为n元随机变量X的数学期望

5.5.2 多元协方差矩阵

记n元随机变量为\(X=(X_1,X_2,\cdots,X_n)'\),若其每一分量的方差都存在,则称

\[ Cov(X) = E[(X-E(X))(X-E(X))']\\ = \begin{bmatrix} D(X_1)&Cov(X_1,X_2)&\cdots&Cov(X_1,X_n)\\ Cov(X_2,X_1)& D(X_2)&\cdots&Cov(X_2,X_n)\\ \vdots&\vdots&&\vdots\\ Cov(X_n,X_1)&Cov(X_n,X_2)&\cdots&D(X_n)\\ \end{bmatrix} \]

为n元随机变量X的协方差矩阵,简称协方差阵

显然,协方差矩阵是一个对称矩阵,并且可以被证明,是一份非负定矩阵。

5.5.3 多元正态分布

n元随机变量\(X=(X_1,X_2,\cdots,X_n)'\),它的每一分量的方差都存在,记X的协方差矩阵为B=Cov(X),数学期望向量为\(a=E(X)=(E(X_1),E(X_2),\cdots,E(X_n))'\),则由概率密度函数

\[ f(x)=f(x_1,x_2,\cdots,x_n)\frac {1}{(2\pi)^{n/2}\lvert B \rvert ^{1/2}}exp\{-\frac 1 2 (x-a)'B^{-1}(x-a)\} \]

定义的分布为n元正态分布,常记为\(X-N(a,B)\),其中\(x=(x_1,x_2,\cdots,x_n)'\),\(\lvert B \rvert\)表示矩阵B的行列式,\(B^-1\)表示矩阵B的逆矩阵,\((x-a)'\)表示向量(x-a)的转置

用矩阵来表示多元正态分布,显得简洁多了

5.5.4 多元正态分布的性质

n元正态分布有一些很好的性质

- n元正态变量\((X_1,X_2,\cdots,X_n)'\)中的任意k元子向量\((X_{i1},X_{i2},\cdots,X_{ik})'\)也服从k元正态分布

- \(X=(X_1,X_2,\cdots,X_n)'\)服从n元正态分布的充要条件是它的各个分量的任意线性组合均服从一元正态分布

- 若\(X=(X_1,X_2,\cdots,X_n)'\)服从n元正态度冷分布,设\(Y_1,Y_2,\cdots,Y_k\)都是\(X_1,X_2,\cdots,X_n\)的线性函数,则\(Y=(Y_1,Y_2,\cdots,Y_k)'\)也服从k元正态分布

- 服从n元正态分布的随机变量X中的分量\(X_1,X_2,\cdots,X_n\)的相互独立的充要条件是它们两两不相关,也等价于\(Cov(X)\)为对角矩阵

- 本文作者: fishedee

- 版权声明: 本博客所有文章均采用 CC BY-NC-SA 3.0 CN 许可协议,转载必须注明出处!